В своей работе по автоассоциатор для текста классификации Хинтон и Салахутдинов показал сюжет , полученный на 2-мерной LSA (который тесно связан с PCA)  .

.

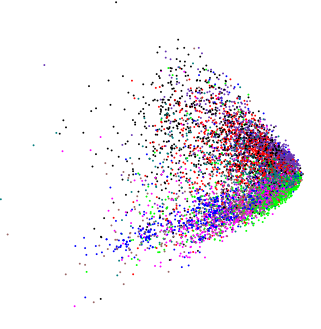

Применяя PCA к совершенно другим слегка многомерным данным, я получил похожий график:  (за исключением этого случая, я действительно хотел узнать, существует ли какая-либо внутренняя структура).

(за исключением этого случая, я действительно хотел узнать, существует ли какая-либо внутренняя структура).

Если мы подадим случайные данные в PCA, мы получим шарик в форме диска, поэтому эта клиновидная форма не случайна. Означает ли это что-нибудь само по себе?

data-visualization

pca

macleginn

источник

источник

Ответы:

Предполагая, что переменные положительные или неотрицательные, ребра ребра - это просто точки, за которыми данные станут 0 или отрицательными соответственно. Поскольку такие реальные данные имеют тенденцию к правильному искажению, мы видим большую плотность точек на нижнем конце их распределения и, следовательно, большую плотность в «точке» клина.

В более общем смысле, PCA - это просто ротация данных, и ограничения на эти данные, как правило, будут видны в основных компонентах так же, как показано в вопросе.

Вот пример использования нескольких нормально распределенных переменных:

В зависимости от поворота, подразумеваемого первыми двумя ПК, вы можете увидеть клин или несколько другую версию, показанную здесь в 3d с использованием (

ordirgl()вместоplot())Здесь в 3d мы видим несколько шипов, выступающих из центральной массы.

А для равномерных положительных случайных величин мы видим куб

Обратите внимание, что здесь для иллюстрации я показываю форму, используя всего 3 случайные величины, поэтому точки описывают куб в 3d. При более высоких измерениях / большем количестве переменных мы не можем идеально представить 5-мерный гиперкуб в 3d, и, следовательно, отчетливая форма "куба" несколько искажается. Подобные проблемы влияют на другие показанные примеры, но все еще легко увидеть ограничения в этих примерах.

Для ваших данных лог-преобразование переменных до PCA вытягивало бы хвосты и растягивало сгруппированные данные так же, как вы могли бы использовать такое преобразование в линейной регрессии.

Другие формы могут возникать на участках PCA; одна такая форма представляет собой артефакт метрического представления, сохраняемый в PCA и известный как подкова . Для данных с длинным или доминирующим градиентом (хорошо известно, что выборки, расположенные вдоль одного измерения с переменными, увеличивающимися от 0 до максимума, а затем снова уменьшающимися до 0 по частям данных, генерируют такие артефакты. Рассмотрим

которая производит крайнюю подкову, где точки на концах осей изгибаются обратно в середину.

источник